我院2020级本科生以第一作者在IJCNN 2023上发表研究成果

51五湖四取四海之财/学院动态2023-04-10 08:32:29来源:51五湖四取四海之财评论:0点击:收藏本文

2023年4月7日,脑机团队成员谢尚宏、郭梓健等2020级本科生团队分别在潘家辉老师和梁艳老师的指导下,在CCF推荐的国际会议IEEE International Joint Conference on Neural Networks 2023(IJCNN 2023)发表了2篇研究论文。

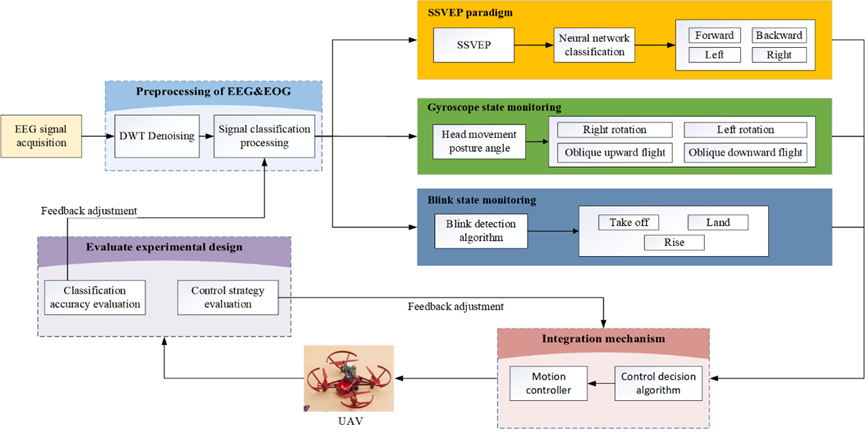

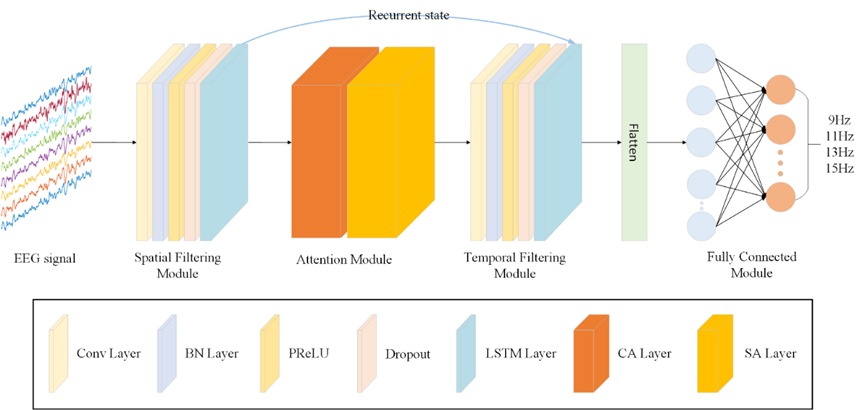

伍庆富、谢尚宏、黄奇安、曾祯的“A Multiple Command UAV Control System Based on a Hybrid Brain-Computer Interface”,针对当前脑控无人机指令少、飞行自由度低、控制准确率差、适用性低等问题,提出了一种基于混合脑机接口和人体姿态信号的无人机控制系统(如图1所示)。该论文的主要贡献为:(1)提出了一种符合人体直觉的、结合了三种生物信号输入源的脑控无人机系统。该系统具备多指令和高飞行自由度的特点。(2)提出了一种用于处理SSVEP信号的深度学习网络(CL-NET),如图2所示,该网络在公共数据集和自建数据集的分类处理上,均取得了最优的结果。(3)在信息传输速率、控制精确度、系统响应时间等各项指标对比中,我们所提出的系统均优于现有的脑控无人机系统。

图1 无人机系统

图2 CL-NET网络

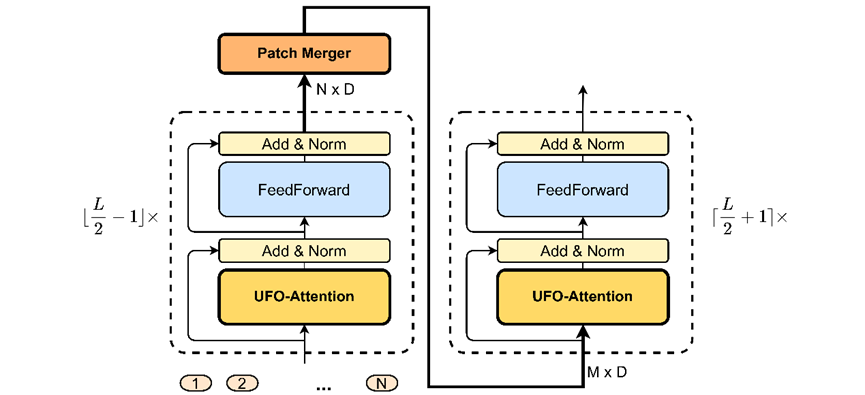

郭梓健、周卓沂的“Engagement Recognition in Online Learning Based on an Improved Video Vision Transformer”,针对线上教育时空分离的问题,提出一种基于改进ViViT的专注度检测模型(如图3所示),用于检测学生实时专注度,教师可根据反馈的学生专注度调整授课方式、进度等,该文的主要研究内容和工作如下:(1)提出了一个基于改进ViViT的模型来检测学生的专注度。该模型兼具计算复杂度低和性能高的优点,有助于应用在线上教育场景。(2)设计了一种名为TELC的transformer encoder(如图4所示)。一方面,采用UFO-attention代替Self-attention,将复杂性从方形水平降低到线性水平,同时提高了时空特征的有效性。另一方面,采用Patch Merger模块来融合patch,在不损失性能的前提下,显著减少了输入patch的数量。(3)提出的方法在Dataset for Affective States in E-learning Environments(DAiSEE)数据集进行评估,在四分类任务中取得了63.91%的准确率,优于其他先进的方法。

图3 专注度检测模型

图4 Transformer Encoder with Low Complexity (TELC) 架构图

IEEE IJCNN是神经网络及相关领域的权威国际会议,由国际神经网络协会(INNS,International Neural Network Society)和IEEE计算智能协会(IEEE-CIS,IEEE Computational Intelligence Society)共同举办。今年将在2023年6月18日至6月23日在澳大利亚昆士兰州的黄金海岸会展中心举行。

撰稿人:郭梓健 谢尚宏

审稿人:梁艳 潘家辉

标签:#论文成果